212

AI 요약

이 글은 AI가 원문을 분석하여 핵심 내용을 요약한 것입니다.

SDUI 성능 병목 해결과 백엔드 최적화

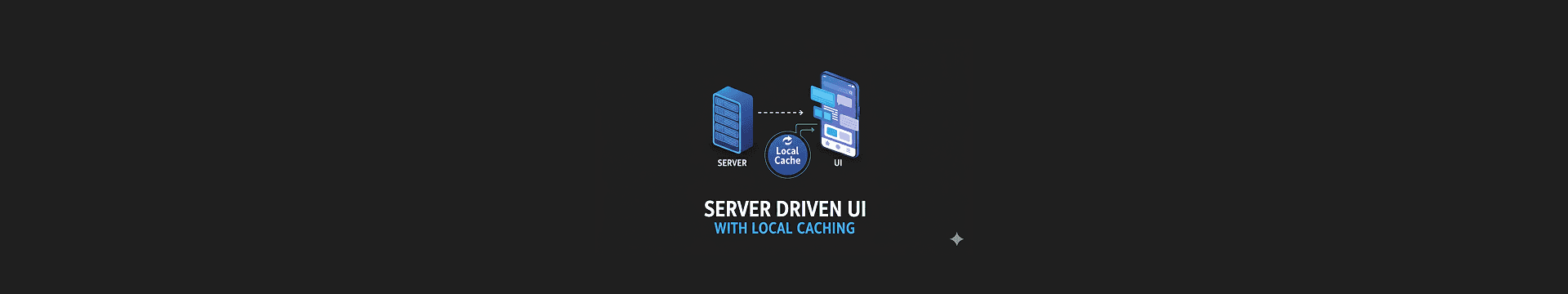

이 게시물은 올리브영이 SDUI(Server-Driven UI) 도입 후 대규모 트래픽 환경에서 발생한 성능 병목 문제를 로컬 캐시 기반의 이중 캐싱 전략으로 극복한 경험을 공유합니다.문제점 및 대응

- SDUI 도입으로 API 응답 속도가 느려지고 네트워크 트래픽 증가

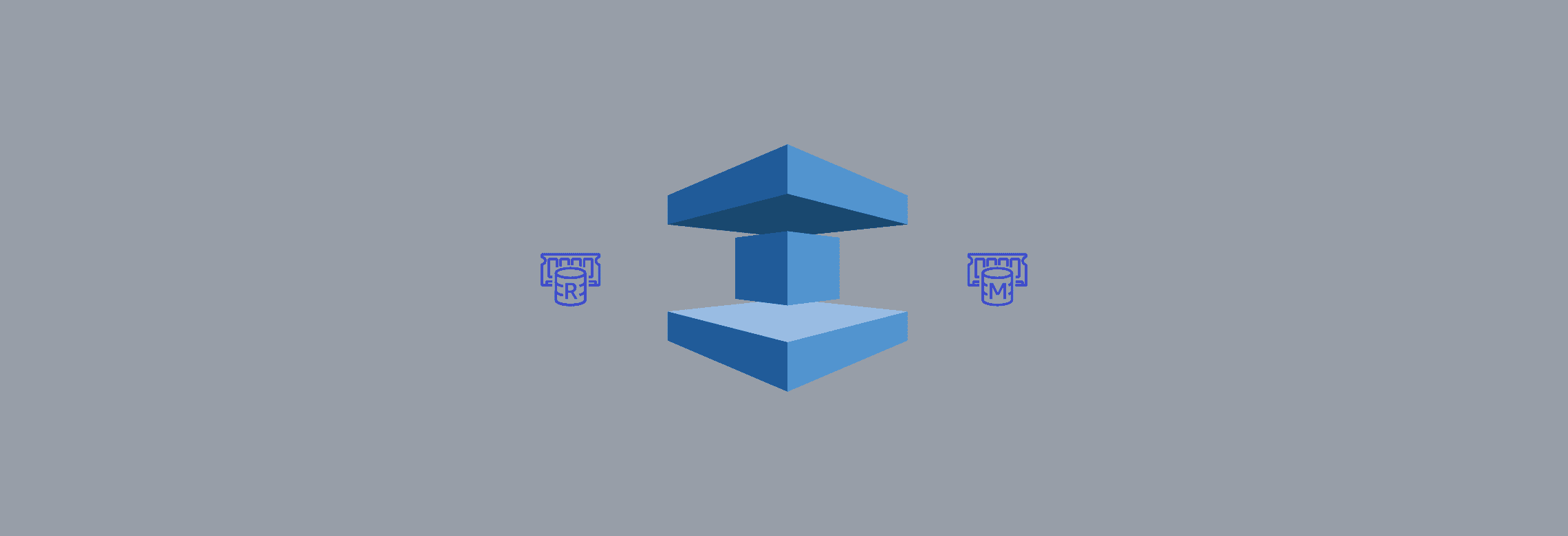

- 1차 캐시로 Caffeine 로컬 캐시, 2차 캐시로 Redis 원격 캐시 활용

- 멱등성 보장과 캐시 무효화 전략(백오피스 연동 즉시 무효화 및 주기적 배치 작업) 적용

구현 및 성과

- Spring Boot와 Kotlin 기반 아키텍처에서 캐시 계층별 역할 분리

- 2025년 '올영세일'에서 최대 6만 건 초당 요청 처리, P90 응답 시간 1ms 미만 달성

- 모든 플랫폼에서 UI 일관성 유지하며 사용자 경험 개선